Jodi— 中国科学院推出的视觉理解与生成统一模型

来源:互联网 更新时间:2025-05-29 17:24

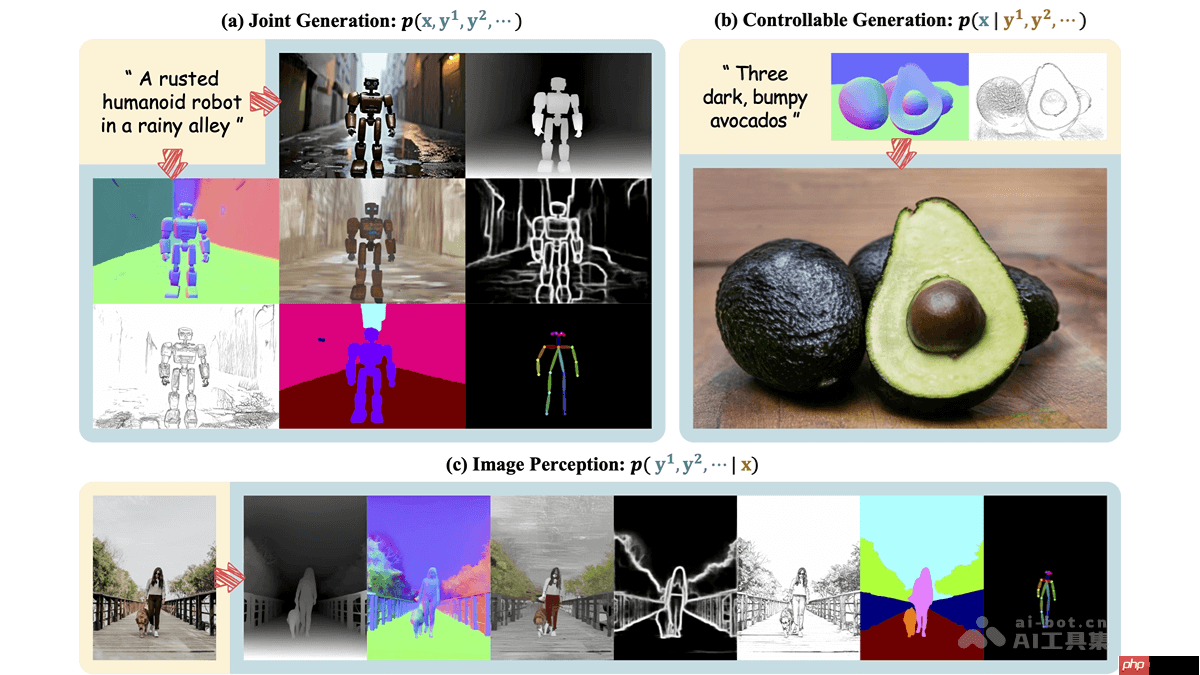

jodi 是由中国科学院计算技术研究所与中国科学院大学共同研发的一种扩散模型框架,其核心在于通过联合建模图像域与多个标签域,将视觉生成与理解功能整合在一起。该框架依托于线性扩散transformer架构,并结合角色切换机制,能够完成联合生成(即同时生成图像及其对应的多个标签)、可控生成(依据标签组合生成特定图像)以及图像感知(从图像中提取多个标签信息)三大任务。jodi 的训练数据来源于 joint-1.6m 数据集,该数据集包含约 20 万张高清图像及与之相关的 7 种视觉领域的标签信息,从而确保了模型在生成与理解任务上的卓越表现,并展现出良好的可扩展性和跨领域一致性。

Jodi 的主要功能

- 联合生成:不仅能生成图像本身,还能同步生成与之相匹配的多种标签,如深度图、法线图、边缘图等,确保生成的图像与标签在语义和空间布局上高度吻合。

- 可控生成:允许用户根据所需特性指定特定的标签作为条件输入,进而控制生成图像的具体属性或外观特征。

- 图像感知:可以从现有图像中准确识别并预测出多个标签信息,涵盖深度估计、边缘检测、语义分割等多个方面,为图像的理解提供了全面的支持。

Jodi 的技术原理

- 联合建模:通过对图像域和多个标签域之间的联合概率分布进行建模,推导出生成任务所需的边际分布和条件分布,从而实现高效的图像生成与理解。

- 角色切换机制:在训练阶段,每个域会被随机赋予生成目标([G])、条件输入([C])或者被忽略([X])的角色,这使得模型能够在同一框架下学会处理不同类型的数据分布,涵盖联合生成、可控生成和图像感知等多种应用场景。

- 线性扩散Transformer:采用线性扩散Transformer作为基础架构,利用线性注意力机制显著降低了计算成本,使模型具备处理大规模多视觉领域数据的能力。此外,还加入了掩码线性注意力和领域不变的位置嵌入技术,进一步提升了不同视觉领域间的一致性和对齐效果。

- 数据集构建:为了满足多视觉领域联合建模的需求,Jodi 创建了一个名为 Joint-1.6M 的数据集,其中包含了超过 20 万张高质量图像及其对应的 7 类视觉领域的自动标注,为模型训练提供了充足且多样化的数据资源。

Jodi 的项目地址

- 官方网站:https://www.php.cn/link/77ebef784ecdb4ce5591340311adb2e9

- GitHub 仓库:https://www.php.cn/link/939a391a1ac9a3431f2d78e83bd8b856

- Hugging Face 模型库:https://www.php.cn/link/c7e791b16611deca87a347c22ce64e11

- arXiv 技术论文:https://www.php.cn/link/c1aa31664c1569818b0494c32981bc4f

Jodi 的应用场景

- 创意内容生成:为创作者提供高效便捷的方式去构思新颖独特的艺术作品或设计项目。

- 多模态数据增强:帮助扩充训练数据集的质量与数量,特别是在缺乏足够标注样本的情况下尤为有用。

- 图像编辑与修复:针对已有图像中存在的缺陷或不足之处进行修补和完善,或者按照用户意愿调整整体风格。

- 视觉理解与分析:通过对图像进行全面细致的标签预测,辅助医疗影像诊断、自动驾驶导航等领域的工作开展。

- 虚拟现实与增强现实:用于创建沉浸式虚拟环境或增强真实世界场景的真实感与交互性,提升用户体验。

-

借呗提前还款有啥影响 借呗提前还款对信用影响解析

-

ao3便捷入口使用说明 ao3最新便捷入口进入

-

ao3中文版网页进入 ao3中文版链接进入2025

-

美图秀秀如何给照片加白边 照片边框添加教程

-

洛克王国世界国王球怎么获取

-

群星纪元星辰莲影是谁

-

a5纸多大尺寸 a5纸具体长宽数据及用途说明

-

大航海时代传说德米尔怎么样

-

波斯王子失落的王冠藏经殿秘密宝箱在哪里

-

REDMI K80 Pro系列官方降价:吃满国补省1000块!2719.15元起

-

大航海时代传说西班牙主线任务怎么完成

-

这城有良田鉴真技能怎么升

-

经典游戏《鬼玩人:游戏》突然各大平台下架 服务器照旧

-

掌门下山萧洛辰伙伴有什么技能

-

洛克王国世界精灵矿工怎么通关

-

洛克王国世界露天挑战什么机制

-

寻道大千四大混沌神兽怎么选

-

桃源记2常见问题答案是什么

-

无限暖暖山海雷泽属性怎么样

-

百炼英雄亚瑟阵容怎么搭配

-

1

- 恐龙岛大猎杀憨豆和猫猫儿下载

- 动作格斗 | 355MB

-

2

- 啵啵世界医院手游安卓版下载

- 益智休闲 | 167.02MB

-

3

- 甜瓜游乐场29.0版国际服游戏下载

- 益智休闲 | 378MB

-

4

- 我的小镇模拟世界下载

- 模拟经营 | 255.10MB

-

5

- 模拟农场24最新版下载

- 模拟经营 | 158MB

-

1 籍贯和户籍所在地一样吗 解析两者区别与联系 05-30

-

2 传前一汽南京CTO陈光加入小米汽车 05-30

-

3 Zapier+DeepSeek:自动化工作流设置与多平台联动 05-30

-

4 大族激光:预测未来几年东南亚PCB产业复合成长率将超中国 05-30

-

6 十公分多长 十公分长度直观展示方法 05-30

-

7 医保卡丢了怎么挂失 医保卡挂失步骤防止被盗刷 05-30

-

8 23公分的鞋是多少码 鞋码与公分对应关系 05-30

-

9 11 个 免费学习 AI 的飞书知识库,完全免费,必须收藏! 05-30

-

10 提示词:拆解品牌场景化3D微缩景观提示词及案例分享 05-30